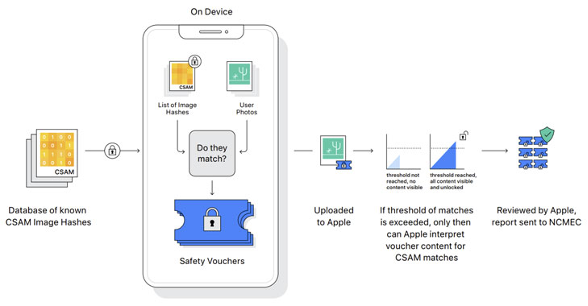

Apple’ın ABD’deki kullanıcıların cihazlarında çocuklara yönelik cinsel istismar içeriklerini tespit edecek yeni bir sistem geliştirdi.

The Hacker News tarafından yapılan habere göre bu teknoloji, bir görselin iCloud’da yedeklenmesinden önce kısaca CSAM (Child Sexual Abuse Material) olarak anılan çocuk taciz ve istismarıyla ilgili içerikleri tarayacak.

Apple, geliştirilen program ile böyle bir içerik tespit edilirse, bunun bir de insan gözüyle değerlendirmesinin yapılacağını ve kullanıcının polise bildirileceğini açıkladı.

Fakat kişisel bilgilerin mahremiyeti kuralını zorlayan bu teknolojinin gelecekte başka yasaklı içerikleri, hatta siyasi görüşleri kapsayacak şekilde genişletilebileceği yönünde kaygılar bulunuyor.

Editör : SavunmaTR Haber Merkezi